2022年に英国企業であるStability AI社が画像生成AIの「Stable Diffusion」を発表し、初心者でもプロ並みのクオリティでイラストが作成できるとして大きな話題となりました。

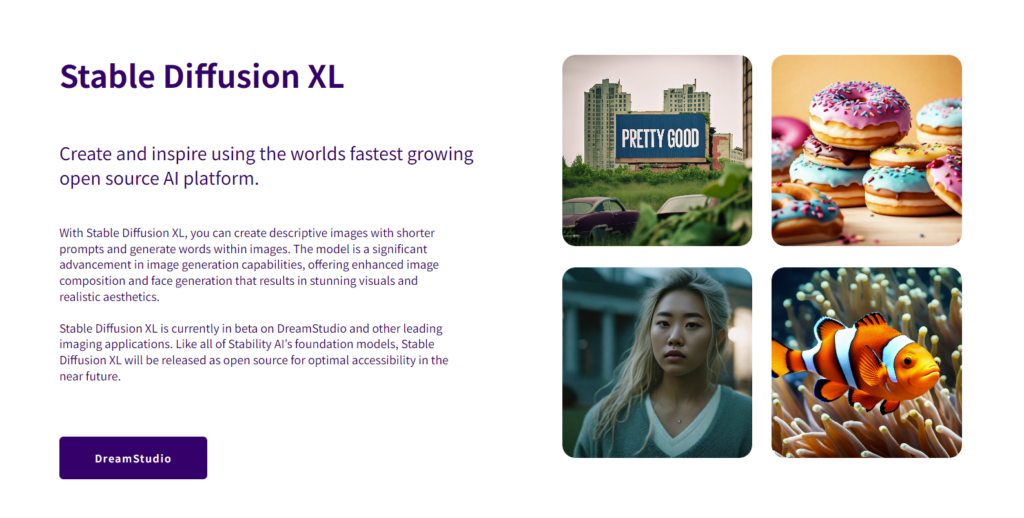

さらに2023年、同社が発表したのがStable Diffusionの画像生成モデルであるSDXL(Stable Diffusion XL)です。

本記事では、従来のStable Diffusionより高品質の画像を生成できるSDXLの概要や最新モデルの「SDXL1.0」の特徴や使い方についても解説します。

高品質だけでなく、さらに自由度が上がった画像生成AIについて知りたい方はぜひ最後までご覧ください。

目次

|SDXLとは

SDXL(Stable Diffusion XL)とは、Stability AI社が開発した画像生成AIであるStable Diffusionの最新モデルです。

研究用途に限定されたSDXL 0.9が先行リリースされ、モデルの表現に影響するモデルパラメーター数が大幅に向上していると共に、テキストと画像の関係を理解するCLIPモデルを使用しているため、高解像度で奥行きのある画像が誰でも簡単に生成可能になりました。

一般的なPCでも動作し、Windows10/11やLinux、Nvidiaなどののグラフィックボードを搭載した環境で利用できます。

SDXLは従来と比較して画像と構図のディテールが大幅に改善された画像を生成でき、高性能な画像生成AIモデルとして注目されています。

|Stable Diffusionとは

Stable Diffusion(ステイブル・ディフュージョン)とは、英国企業であるStability AI社が開発した入力したテキストに基づき画像生成するAIモデルです。

2022年8月に初版がリリースされ、ミュンヘン大学のCompVisグループが開発した潜在拡散モデル(latent diffusion model)を基にしており、深層生成ニューラルネットワークを使用しています。

プログラミング言語はPythonを使用し、CUDAカーネルをサポートしている任意のOSで利用可能であり、モデルの最新版は2022年12月7日にリポジトリで公開されました。

Stable Diffusionは、テキストから画像を生成できるだけでなく、商用利用もできるため、クリエイターにとって便利なツールとして注目されています。

さまざまな用途に応じてテキストから画像を生成することで、多岐にわたるクリエイティブな活用ができます。

|SDXL1.0とは

SDXL1.0とは、Stable Diffusionを開発したStability AI社の最新画像生成AIモデルです。

開発されたモデルの中で、最も高品質な画像生成AIであり、他のオープンモデルとの比較テストにおいても高い評価を受けています。

本モデルはStability AI社のプラットフォームを通じて利用可能であり、ClipDropやGitHubでもアクセス可能です。

SDXL1.0の新しいアーキテクチャは、非常に大きなパラメータ数を持ち、潜在拡散の専門家の組み合わせに基づいています。

このアーキテクチャによって、速度や計算リソースの過剰使用を抑えつつ、堅牢な画像生成を実現しました。

幅広いスタイルやコンセプトに対応し、高品質な画像生成を実現するための優れたツールとして、今後もさまざまな場面で活用が期待されるでしょう。

|SDXLの特徴

最新の画像生成AIモデルであるSDXLのおもな特徴は以下の通りです。

高画質な画像生成が可能になる

影や手の描写が改善されている

詳しく解説していきます。

高画質な画像生成が可能に

SDXL1.0の1つ目の特徴は、従来モデルより高画質な画像生成ができることです。

現実に近いフォトリアリスティックな表現を得意とし、1024×1024ピクセルの高品質画像をさまざまなスタイルで生成できるようになりました。

またシンプルなプロンプトでも高品質な画像を生成できるため、修飾語の組み合わせに頼らず利用できます。

これによりユーザーはだれでも簡単かつ迅速に魅力的な画像を生成することができます。

本モデルは、画像生成AIの新たなステージであり、高品質な成果物を容易に作成するための優れたツールとしてさまざまな場面で活用が期待されています。

影や手の描写が改善

SDXL1.0の2つ目の特徴は、従来モデルより生成された画像の影や手の描写が改善されたことです。

従来モデルでも十分に鮮明な表現でしたが、コントラストや照明、影が改善され、より鮮明な画像としてAIが生成します。

影の表現や手のディテール描写が向上したことにより、現実に近い視覚体験を実現しました。

このアップデートにより、立体感や質感をより精緻に表現することができ、映像や画像のクオリティが向上します。

影や手の表現が改善されることで、より没入感のあるコンテンツを提供できるでしょう。

幅広い分野で高い評価を受けており、映画、ゲーム、デザインなどのさまざまな領域でのクリエイティブな活動において、新たな可能性を切り拓くことが期待されています。

|SDXLの導入方法

SDXLを使用するためには、以下の手順に従って導入しましょう。

①AUTOMATIC1111 WebUIへアップデートする

SDXL 1.0を使用するには、AUTOMATIC1111 WebUIをv1.5.1以上にアップデートする必要があります。

②必要なモデルをダウンロードする

Baceモデルは必須なので「sd_xl_base_1.0.safetensors」のダウンロードと、画質向上が期待されるRefinerモデル「sd_xl_refiner_1.0.safetensors」も同時にダウンロードしておきましょう。

最後にVAE「sdxl-vae」もダウンロードしておきます。

③モデルファイルを所定フォルダに指定する

各モデルのダウンロードが完了したら下記のフォルダに移動します。

webui\models\Stable-diffusion

VAEは下記のフォルダに移動します。

webui\models\VAE

以上でSDXLの導入は完了です。

|SDXLに必要なモデル

SDXL1.0の画像生成は、以下のモデルで構成されています。

Base(ベース)モデル

Refiner(リファイナー)モデル

それぞれ詳しく解説します。

Baseモデル

基本モデルである「Baseモデル」は、SDXLを使用するためには必須のファイルです。

SDXL1.0で高画質な画像を生成するためには、BaseモデルとRefinerモデルが必要ですが、Baseモデルの単独でも画像生成はできます。

プロンプト入力後、最初の段階で3.5B(35億)パラメーターを持ったBaseモデルが128×128ピクセルの画像を生成する仕組みであり、単独でもクオリティが劣ることなく、高解像度の画像生成が期待できるでしょう。

Refinerモデル

Refinerモデルは、上記のBaseモデルで生成した画像をさらに高画質な画像に処理する役割を果たします。

Baseモデルで生成した128×128ピクセルの画像を6.6B(66億)パラメーターのRefinerモデルで1024×1024ピクセルにアップし、高画質な画像を生成する2段階で処理する仕組みです。

しかしながら現時点でWebUI で完全にサポートされてないため、手間がかかりますが手動でおこなう必要があります。

|SDXLの使い方

SDXLの導入が完了したら、実際の使用方法について解説します。

おもな使用方法は以下のとおりです。

Baseモデルのみ使う

BaseモデルにRefinerモデルを組み合わせる

それぞれ詳しく解説します。

Baseモデルのみ使う

まずはBaseモデルのみ使う方法を解説します。

以下の手順で設定しましょう。

1.Baseモデル「sd_xl_base_1.0.safetensors」を選択する

2.VAE「sdxl_vae.safetensors」を選択する

3.サンプリング方法を選択する

ここでは自身の好みのものを選択しましょう。迷った場合は「DPM++ 2M SDE Karras」を選択します。

4.画像サイズを選択する

基本的にSDXLでサポートされているサイズに設定しましょう。迷った場合は1024×1024を選んでおけば安心です。

以上の設定をおこない、プロンプトを入力すれば画像が生成されます。

BaseモデルにRefinerモデルを組み合わせる

BaseモデルにRefinerモデルを組み合わせて使用する方法について解説します。

以下の手順で設定しましょう。

1.Baseモデルで画像を生成する

2.生成した画像をimg2imgに転送する

3.モデルをRefinerに切り替える

4.「Denoising strength」を2〜4にする

5.「Generate」で画像を生成する

上記でも述べたとおり、RefinerモデルはWebUI で完全にサポートされてないため、手間のかかる方法でしか利用できません。

しかし画像のコントラストや影などの細部にわたり、クオリティの向上が期待できるので、Refinerモデルを組み合わせる方法にも挑戦してみましょう。

|まとめ

いかがでしたか。

今回はSDXL1.0の特徴や使用方法について解説しました。

従来モデルから大幅に改善された点は、1回の画像生成で2回のプロセスを経て処理していることです。

その結果、1024×1024の高解像度の画像が生成可能であり、Clipdropを使用した簡単なプロンプトで誰でも簡単に多彩なスタイルを表現できます。

従来のStable Diffusionとの互換性はなく、一部の機能が制限されていますが、SDXLは今後さらなる進化が期待されています。商用利用も可能なので、ビジネスとしての展開もされるでしょう。

今後も生成AI市場は盛り上がることが予想されるため、SDXL1.0を実際に試して、高品質な画像生成を楽しんでみてはいかがでしょうか。

TWITTER

TWITTER

FACEBOOK

FACEBOOK

はてブ

はてブ